Escrevi o texto abaixo entre Novembro e Dezembro de 2023 e o publiquei em @mattinavictor no instagram. Posteriormente o apaguei dali por conta das diretrizes de serviço da plataforma em relação a publicação da imagem forjada da prisão de Donald Trump, ainda que esta tenha sido contextualizada no âmbito da argumentação. Republico-o integralmente abaixo.

Autalização 22/02/24: corrigi uma confusão entre os termos ‘dataset’ e ‘modelo’ no início do texto e inseri a imagem da matéria da Bloomberg que ilustra o conceito de viés de IA.

Quando os carros apareceram tememos pelo futuro dos cavalos. Com as Inteligências Artificiais, os cavalos somos nós. Para entrarmos mais preparados nos debates futuros penso que precisamos considerar os seguintes pontos:

As IA funcionam por datasets, que são volumes assustadoramente grande de dados que treinam modelos de comparação, e para formar esses datasets as IAs precisam varrer a rede atrás de material. Grosso modo varrer a rede e coletar é roubar e isto se chama webscraping. O webscraping é uma prática de mais de 30 anos e que ocupa uma zona cinza da entre a preservação de dados e a pirataria.

O modelo treinado a partir dos datasets compara valores numéricos de bilhões de imagens, mas não as retém propriamente dito, e sim apenas as comparações. É como se um falsário com uma memória fotográfica lesse sem tirar da biblioteca todos os livros de arte e aprendesse tudo a partir das tantas fotografias que viu. Este falsário poderia apenas produzir "trabalhos novos" dos artistas que roubou e também poderia unir as referências e gerar "artistas" derivativos. Portanto as IAs não são nem preservadores de dados nem piratas exatamente, mas falsários.

A meu ver, não há, até o momento, como compensar financeiramente todo mundo de quem as IAs roubam porque todos nós teríamos de ser compensados. Havia um golpe hacker muito famoso na década de noventa que consistia em roubar um centavo de todas as contas do CitiBank, um banco notoriamente pobre no quesito segurança de rede. A massa crítica dos centavos fazia milhões de dólares pingarem insuspeitos na conta do ladrão. Ninguém reclamaria por causa de um centavo e é por isso que o webscraping funciona. "Ah, mas o artista tal teve todo seu material roubado". Sim, ele e todos os outros quadrinistas, ilustradores, fotógrafos, pintores, designers, cineastas, cartógrafos, gravuristas, cartunistas, publicitários, arte finalistas e inclusive gente que posta suas imagens de IA alteradas de volta na web. A suposta falta de critério para o webscraping elimina a possibilidade de imaginar uma justa compensação.

Tanto na forja do falsário quanto na geração de imagens por IA, há um jogo de convencimento e checagem. O falsário pega um chassi antigo, uma tela usada, remove sua tinta original, a suja de poeira e mofo e imagina o artista copiado através dos pigmentos e técnicas da época para tentar ultrapassar o bom juízo do avaliador. Se for ludibriado, o expert perde a disputa. Também a IA passa por um jogo de checagem chamado de rede adversarial, onde um classificador, seja ele programado ou humano, avalia e pontua os resultados gerados pela IA. Não há para as empresas de IA um motivo para fazer parar de crescer seus datasets e aperfeiçoar seus modelos, já que ampliá-los e treiná-los é sinônimo de aumento da capacidade de gerar resultados mais consistentes, ou seja, de vencer o classificador na rede adversarial e fazer isso rápido.

Acontece que um falsário é bem sucedido se for capaz de pôr em dúvida certas decisões do artista forjado. Precisa levar em consideração as limitações, hesitações, erros e arrependimentos de quem imita. A forja convincente esconde decisões humanas imaginadas.

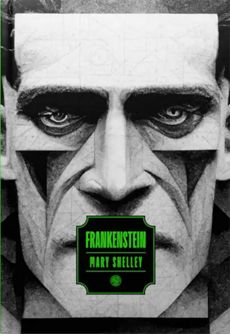

Atualmente o Midjourney, ferramenta usada pelo designer Vicente Pessôa para a capa de Frankenstein que concorreu ao Prêmio Jabuti de 2023 até ter sua inscrição retirada, está na versão 5 de seu algoritmo. A cada versão, o trabalho de convencimento da rede adversarial e do público se torna mais eficaz. A versão número 4 da ferramenta é descrita desta forma no site da ferramenta: "O modelo Midjourney mais recente tem mais conhecimento sobre criaturas, lugares, objetos e muito mais. Ele é muito melhor em acertar pequenos detalhes e pode lidar com prompts complexos com vários personagens ou objetos." Acredito que Vicente tenha utilizado a versão 3 do programa, rudimentar e em desuso. Talvez na época da confecção do livro esta fosse a mais moderna, ou talvez ele tenha optado por utilizar uma versão antiga por mera escolha estética. A questão é que na versão 3 era mais difícil esconder as imprecisões oriundas das alucinações da máquina e qualquer pessoa que se acostumasse aos resultados derivativos das IA detectariam imagens geradas por inteligência artificial como tendo "cara de IA".

capa do livro Frankenstein de Mary Shelley co-criada por Vicente Pessôa e Midjourney

Diferenciar imagens geradas por IA das feitas por humanos torna-se cada vez mais difícil, na medida em que os caminhos algorítmicos que poderiam ser percebidos como "decisões da máquina" se confundem com as escolhas de um artista digital profissional. Cada nova versão supostamente supera os limites generativos da versão anterior, seja através de um aprimoramento das capacidades comparativas da rede generativa, seja através da robustez do dataset, e consequentemente do modelo treinado. Disse que supostamente a nova versão supera os limites da anterior porque em verdade parece existir também o crescente interesse na redução da chance de erro.

Erros aqui são as aberrações que saltam aos olhos - mãos com dezesseis dedos, olhos com duas pupilas etc. Apesar de dizermos que a "máquina alucina imagens" a tendência é a de higienização desta alucinação para que a IA se torne um falsário competente, ainda que limitado. Este limite aumenta também com o número de termos considerados "problemáticos" pelos desenvolvedores das IAs, banidos aberta ou secretamente. No caso do Midjourney, ao solicitar um termo pornográfico ou que tendencie a situações violentas como "cena de crime" ou até mesmo "cirurgia" você receberá um aviso dizendo que a palavra não pode ser usada. Estes limites impostos pela empresa aumentam na medida em que o software "melhora" - a cada versão nova, certos processos são corrigidos e eliminados fazendo com que as versões anteriores sejam capazes de produzir erros de um jeito peculiar, proibido às novas versões.

Existe ainda um outro tipo de erro que não havia sido antecipado - o da forja da situação realística falsa. Esta imagen gerada por IA retrata a prisão do ex-presidente americano Donald Trump. A ferramenta usada foi também o Midjourney e após chamar a atenção da imprensa, o usuário foi banido e a empresa implementou uma política nova onde associações de termos podem ser consideradas problemáticas e então são bloqueadas, mas o solicitante ainda pode apelar pela revisão. Aos poucos delineiam-se os limites éticos da implementação e do uso da ferramenta enquanto a suposta capacidade emulativa do aparelho resseca.

detalhe da imagem forjada pelo Midjourney

As IAs de geração de imagem são consideradas "de baixo risco" quando comparadas às médicas ou de transporte. Para o bom funcionamento basta se certificar que o aparelho se ocupa de coibir os resultados problemáticos e funcione sem propagar erros. No entanto, há ainda mais um problema em curso - o de hackers contra as redes adversariais. Anish Athalye mostrou em seu github (https://github.com/anishathalye/obfuscated-gradients) como fez para "poluir" o treinamento do classificador que avalia imagens geradas por IA a "confundir" a imagem de um gato com a de guacamole e assim pôs em dúvida a robustez de segurança das redes adversariais.

descrição visual do projeto de perturbação adversarial por Anish Athalye

Isto é grave para os desenvolvedores porque representa um ataque de fora contra parte fundamental do aparelho, que por força do ataque teria voltado a um estágio anterior, supostamente superado, de imprecisão comparativa por infecção. Remediar esta questão é complicado e pede a reformulação do aparelho e dos termos de serviço para incluir ação jurídica, o redirecionamento do capital da empresa para outro modelo adversarial mais seguro, e de pressão política por mais regulamentação contra agentes externos.

Um forte ponto desta regulamentação deseja determinar quem pode e quem não pode ter sua própria IA, seja ela feita em casa ou encomendada. Para isso, é necessário construir o argumento de que IAs são potencialmente perigosas se cairem nas mãos erradas. O clamor pela regulamentação raramente admite adubar o terreno para um oligopólio e tampouco ouvimos falar de leis contra o web scraping. Existe a possibilidade de remoção de acesso a determinado conteúdo se for comprovador que pertença à propriedade intelectual de um artista que o reclama, mas me pergunto se o modelo também será treinado novamente para esquecer o material do plágio. Aposto que não. A responsabilização propriamente dita parece sempre recair sobre um "mal funcionamento do aparelho", que ao menor sinal de problema é atualizado e "corrigido".

A correção do aparelho em si não é um problema, mas blinda as práticas dos profissionais por trás de softwares caixa-preta. Dada a natureza dos programas digitais, que são somatórios volumosos de funções matemáticas complexas, os processos técnicos ficam invisibilizados atrás de suas interfaces gráficas de usuário (GUI). Com as redes neurais, o volume dos processos e a velocidade fogem do controle e certos erros das IAs causam enorme prejuízo também às empresas. O CEO da Google, Sundar Pichai, ao dizer publicamente em Abril deste ano que ninguém da empresa realmente compreende o modo como a IA Bard formula algumas de suas respostas acabou explicando porque meses antes a mesma IA afirmou erroneamente durante uma demonstração pública que o telescópio James Webb produziu a “primeira imagem de um planeta fora do sistema solar”, o que prejudicou em 100 bilhões de dólares a avaliação da Google pelo conglomerado Alphabet Inc., que a detém.

O reconhecimento de padrões que formula a base do algoritmo comparativo tanto se utiliza quanto reforça estereótipos, o chamado "viés de IA". A ponte probabilística que liga um termo a uma imagens faz transparecer o modo como o classificador da rede adversarial se distancia de uma ideia de inteligência para tornar-se um forjador de simulacros que dependem de meios engenhosos para driblar a tendência da máquina à resposta empobrecida de realidade. Veja em (https://www.bloomberg.com/graphics/2023-generative-ai-bias/).

O viés da Inteligência Artificial reforça associações excludentes tanto raciais quanto de gênero

Também as IAs são capazes de depredar a percepção de valor do trabalho de artistas visuais, substituindo a criação por derivativos automáticos. A despeito dos erros que produz acidentalmente, as IAs tornam evidente o desequilíbrio competitivo entre os processos humanos e não-humanos, e isto é algo que está programado no aparelho. Sobre seus construtores conseguimos dizer que quando solicitamos a geração de imagem, estamos optando por um serviço cujas políticas são tornadas claras apenas quando as coisas vão mal e que são reescritas sob pena de ação judicial e/ou boicote, ainda que muitos dos problemas mais evidentes careçam de solução efetiva.

Nas últimas semanas muito aconteceu no mundo das IAs e o que escrevi ficará datado em breve, se já não o estiver. Recentemente a impressionante IA francesa Mistral disponibilizou seu modelo sem qualquer custo através de um magnet link de torrent. Não compreendo o que está por trás da startup ou de seu MoE (Mixture of Experts), mas se pudermos ter nossas IAs, não precisaremos endereçar a terceiros nossos prompts futuros e isto é algo a se levar em conta. Evito abrir novas considerações porque penso que a Mistral e outras novas IAs de código aberto mudarão todo o ambiente e a discussão técnica, ética e legal.

Dito isto preciso esclarecer que eu mesmo acho a geração terceirizada de imagens por IA interessante como terreno fértil à surpresa e ao caos da aleatoriedade. Pessoalmente encaro as IA como componentes de um processo dialógico parecido com tentar convencer um chef de cozinha temperamental a bolar um prato ruim. Funciona assim - dou uma ideia e mais um somatório de acasos que provocam algo diferente do que eu havia pensado de início. Preciso que ele tente o maior número de combinações esdrúxulas porque quero que erre. Quase nunca consigo utilizar o que a IA me dá, mas às vezes a sua ideia é melhor do que a minha. É um processo que me provoca a produzir algo lateral ao que eu faria sem sua companhia.

Prefiro ter na IA um assistente desajustado a quem posso dar cada vez mais chances de falhar, porque quando trabalhamos juntos é como se minha imaginação ganhasse uma órtese que a obrigasse a considerar insistir na aparência das coisas como uma ilusão assumida e abertura para algo ao mesmo tempo incompleto e inconcebível. Uma espécie de "miragem ciborgue" que por vezes carrega semelhanças em tom e conteúdo à visão mística, alienada de promessas de libertação.

Esta iconolatria pura assistida por máquinas não é automaticamente niilista a meu ver, porque devolve ao espectador humano o poder de articulação de uma superfície que virtualiza o sentido enquanto mantém a aparência do mundo. É na superfície paradoxal de algo produzido pelo jogo de correlações entre a máquina matemática e a nossa linguagem que uma imagem pode ser ao mesmo tempo mutante e inexorável.